知识

[大模型]离线更新本地ollama模型,拷贝ollama模型到离线电脑中安装使用deepseekR1模型更新增量更新update models

[大模型]使用chatbox和open-webui同时调用ollama管理器cs模式和bs模式同时使用,调用ollama:11434端口连接被对方重设关联deepseek

[大模型]ollama工具升级docker中升级ollama下载速度很慢的解决方案

[大模型]ollama容器离线升级ollama手动升级0.6.8

本文档使用 MrDoc 发布

-

+

首页

[大模型]使用chatbox和open-webui同时调用ollama管理器cs模式和bs模式同时使用,调用ollama:11434端口连接被对方重设关联deepseek

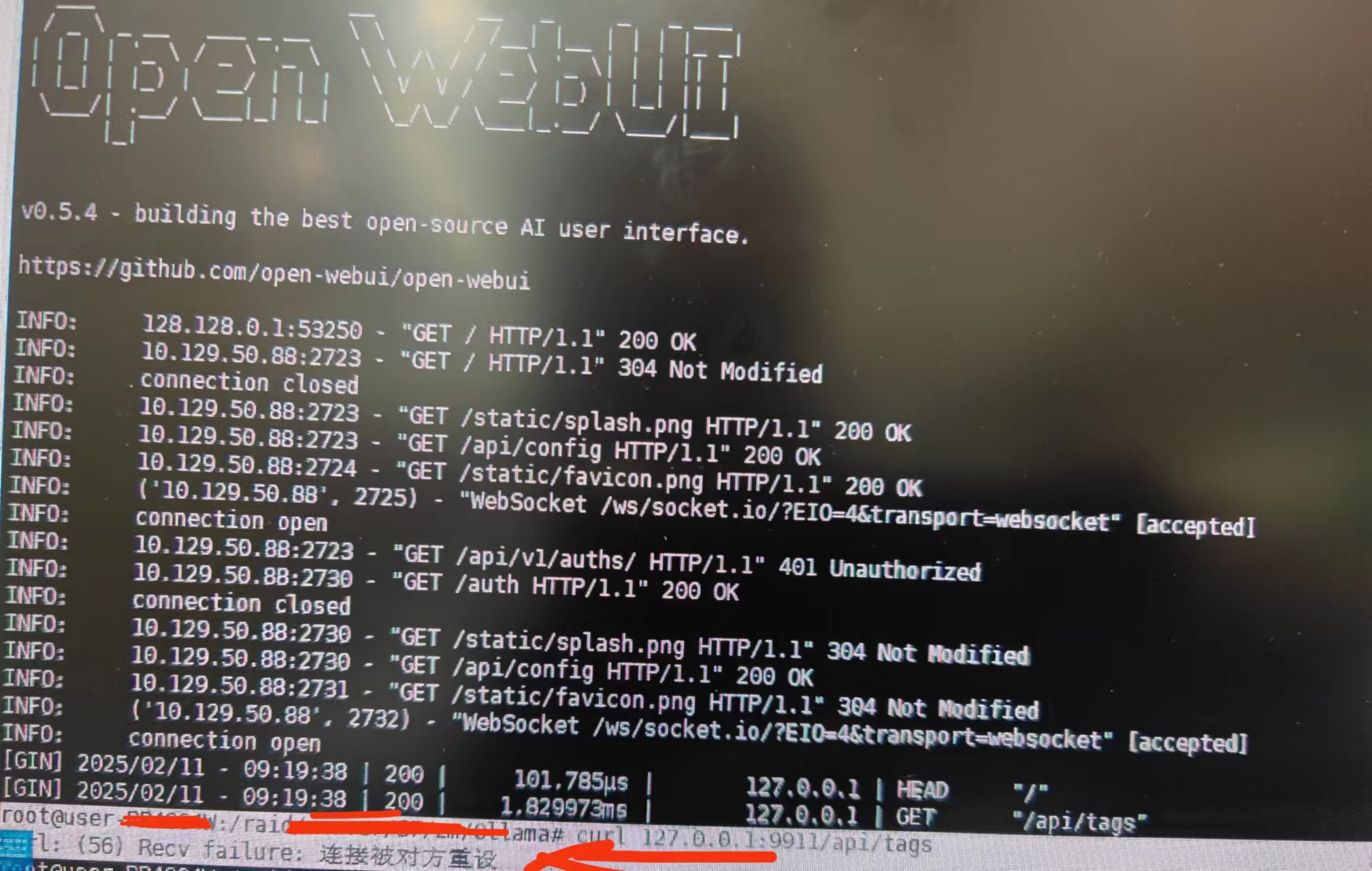

# 说明 由于有同事想要chatbox调用ollama,所以有此文章。 主要也是ollama在windows部署起来也是很简单的,如果内网中,多个机器部署还是有些浪费资源,故想要使用chatbox直接调用服务器上的ollama就好了。 这里的ollama是通过容器的方式部署在了GPU服务器上,Linux服务器为open-webui提供服务。最近又更新了deepseek R1模型,所以理论上是可以通过chatbox调用容器中的ollama接口进行提供服务的。 但是,事情好像没有想象的简单... 按照正常的暴露ollama的端口将11434端口暴露给主机,一直是提示“连接被对方重设”。 真是莫名奇妙,8080端口可以正常暴漏,就这个不行。但是进入容器,服务又是正常的...防火墙也关了...  # 连接被对方重设解决方案 最后经过仔细查看,怀疑应该是环境变量OLLAMA_HOST的问题,默认是OLLAMA_HOST=127.0.0.1:11434 这里可以修改11434,但是其实是127.0.0.1的问题。如果是本机运行,127.0.0.1没问题,但是如果是容器中,已经经过nat,那么127.0.0.1就无法映射出来。 ==故这里将OLLAMA_HOST=http://127.0.0.1:11434改为OLLAMA_HOST=http://0.0.0.0:11434即可。== **这个环境变量在启动容器的命令中修改。** ```bash docker run -d -p 3000:8080 -p 4000:11434 --gpus=all -v /raid/Test/ollama:/root/.ollama -e HF_HUB_OFFLINE=1 -e OLLAMA_HOST=http://0.0.0.0:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama ``` 使用上面命令重启容器即可正常暴露11434服务了。 到这里就可以愉快使用chatbox和open-webui同时连接同一个ollama工作了。 编辑:myhappyandy

虚拟世界

2025年2月12日 23:05

转发文档

收藏文档

上一篇

下一篇

手机扫码

复制链接

手机扫一扫转发分享

复制链接

Markdown文件

分享

链接

类型

密码

更新密码