知识

[大模型]离线更新本地ollama模型,拷贝ollama模型到离线电脑中安装使用deepseekR1模型更新增量更新update models

[大模型]使用chatbox和open-webui同时调用ollama管理器cs模式和bs模式同时使用,调用ollama:11434端口连接被对方重设关联deepseek

[大模型]ollama工具升级docker中升级ollama下载速度很慢的解决方案

[大模型]ollama容器离线升级ollama手动升级0.6.8

本文档使用 MrDoc 发布

-

+

首页

[大模型]ollama容器离线升级ollama手动升级0.6.8

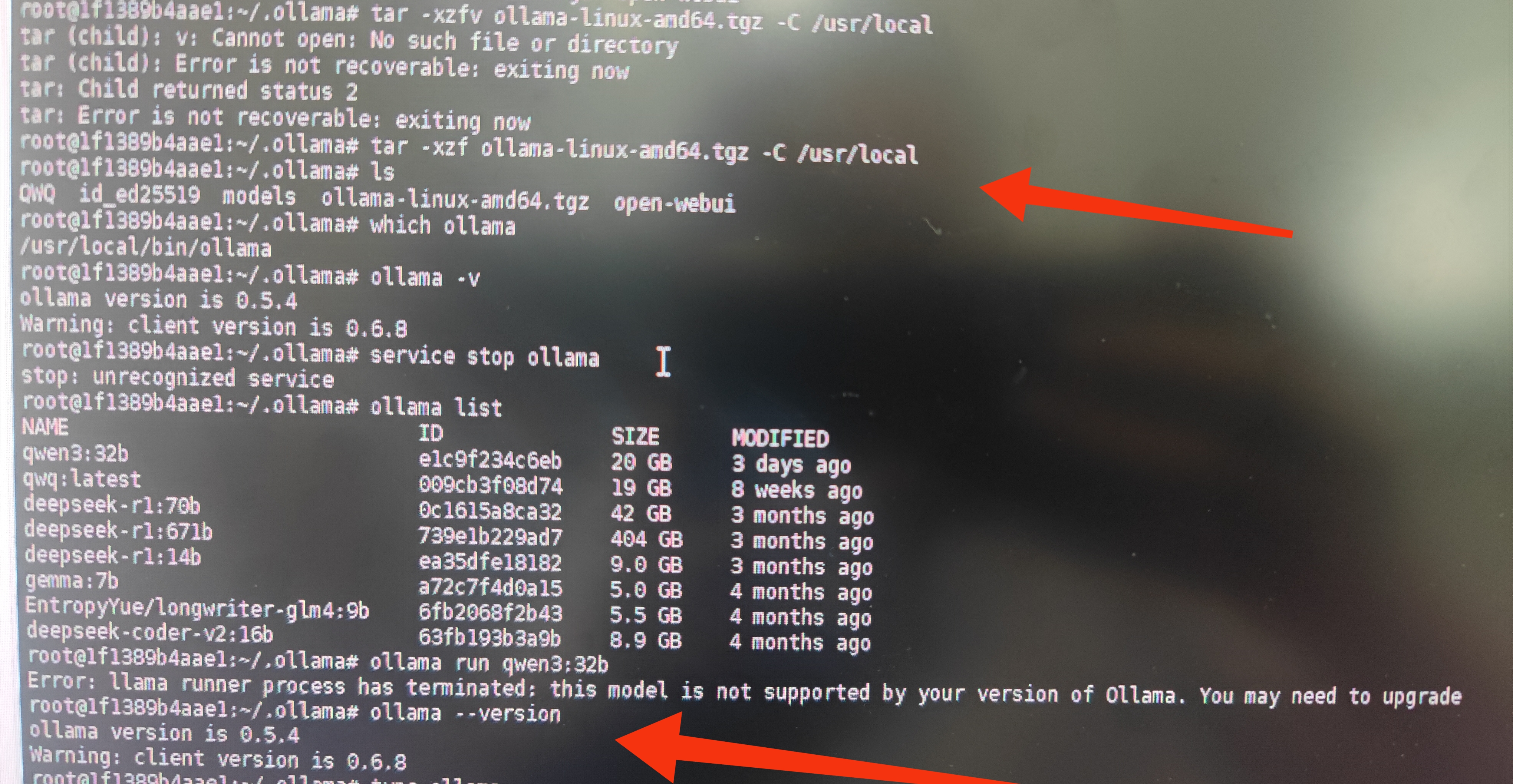

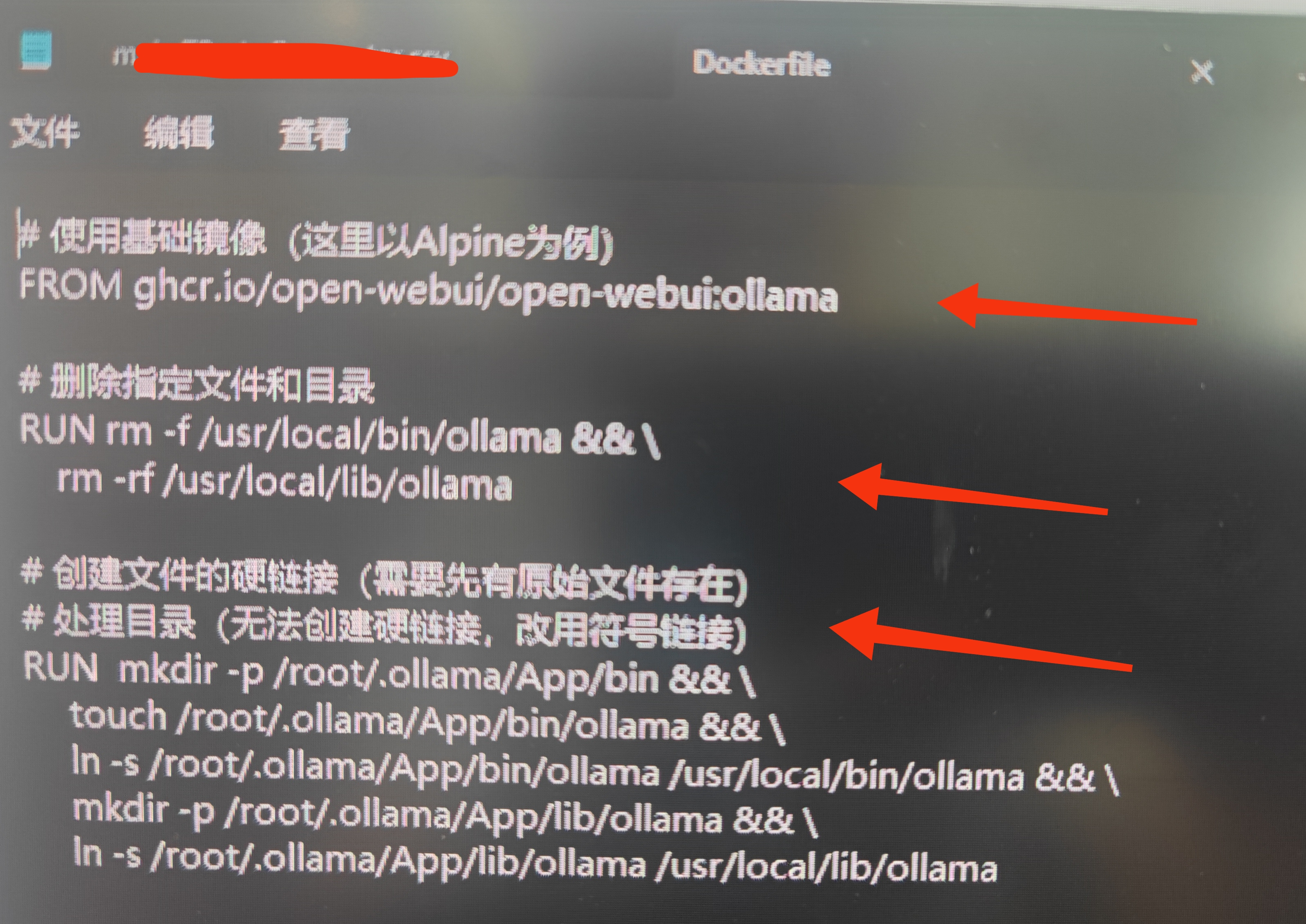

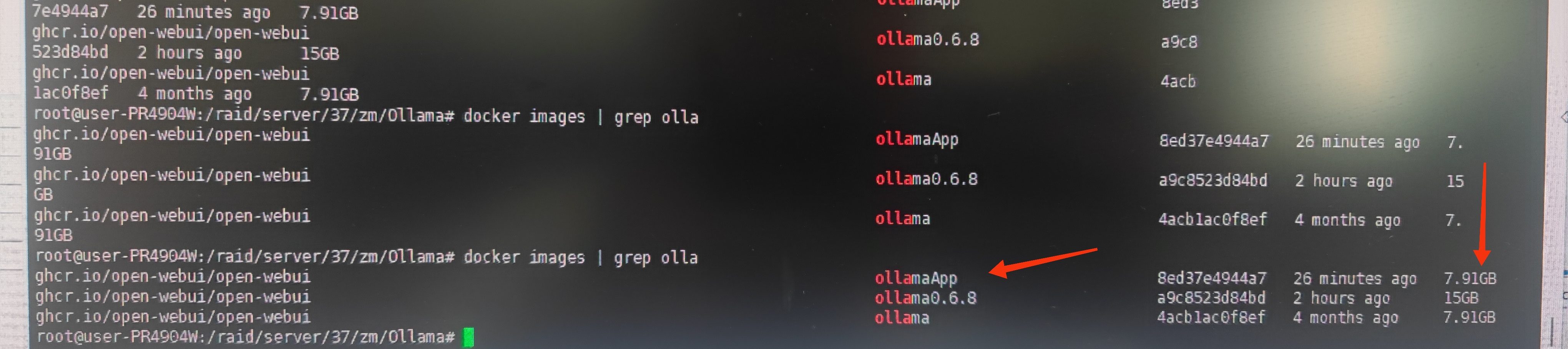

# 说明 前面介绍过ollama升级的过程,但是咧,太麻烦,太慢,太不可行。 经过测试,今天给出简单好用的升级方法。 # 升级方法 ## 下载.tgz安装包 用浏览器下载,通过github加速的方式下载,github上搜索ollama,找到最新稳定版0.6.8版本。 ## 拷贝到容器(登陆容器内操作) 拷贝到容器中,并用命令解压 ```bash tar -xzf ollama-linux-amd64.tgz -C /usr/local ``` 理论上到这里就已经安装完了, /usr/local是ollama默认安装位置,解压后的bin和lib目录会覆盖替换。 ## 运行警告 到这里就可以测试是否正常,但是但是,有可能会提示warning ollama version is 0.4.5 ollama client version is 0.6.8  要解决这个问题,只需要重启机器就行,但是是容器,最好是commit之后,再重启容器就OK了 ```bash docker commit [容器id] -t [新的镜像名称] ``` 再运行新的镜像就OK啦! # 高级操作(在主机操作) 高级处理需要将ollama程序放在镜像外面,通过映射到镜像内部即可,以后更新,无需每次都更新镜像,只需要覆盖映射前的内容即可。 这里通过Dockerfile建立一个通用镜像,通过映射将ollama运行程序放置到运行目录。 ## 将下载的tgz文件解压到一个目录 ==该题目需要通过卷方式映射到镜像内。== 可以是将要映射到镜像内的模型所在目录的父目录。 例如本机上/ollama是需要映射的目录,那么/ollama/models是模型目录,/ollama/App是解压的目录。App是tgz解压文件存放的目录。 ```bash tar -xzf ollama-linux-amd64.tgz -C /ollama/App ``` ## 新建一个Dockerfile文件内容为 ```yaml #使用基础镜像 FROM ghcr.io/open-webui/open-webui:ollama #删除指定文件和目录 RUN rm -f /usr/local/bin/ollama &&\ rm -rf /usr/local/lib/ollama #创建文件的软链接(需要镜像中先有原始文件存在,不然会报错,不要用硬链接) #处理目录(需要中先创建该目录,无法创建硬链接,改用符号链接) RUN mkdir -p /root/.ollama/App/bin && \ touch /root/.ollama/App/bin/ollama && \ ln -s /root/.ollama/App/bin/ollama /usr/local/bin/ollama && \ mkdir -p /root/.ollama/App/lib/ollama && \ ln -s /root/.ollama/App/lib/ollama /usr/local/lib/ollama ``` ==Dockerfile内容是要将主机映射到容器的ollama通过软链接的形式放到/usr/local/bin和lib下。因为原ollama就安装在这个目录下。==  ==相当于主机映射到容器内目录,容器内再将ollama执行文件链接到执行目录下,以后就可以只替换主机目录中的ollama即可升级!== ## docker build生成新镜像 ```bash docker build -t ghcr.io/open-webui/open-webui:ollamaApp . ``` ==这样生成的镜像会明显比commit的镜像小很多==  ## 运行测试 docker run起来,跟之前的方式一样,将新镜像跑起来 编辑∶myhappyandy

虚拟世界

2025年5月16日 16:25

转发文档

收藏文档

上一篇

下一篇

手机扫码

复制链接

手机扫一扫转发分享

复制链接

Markdown文件

分享

链接

类型

密码

更新密码